引言

大型语言模型,例如 GPT(生成式预训练变换器),已成为人工智能 (AI) 领域各种应用的强大工具。然而,公司应该谨慎地避免过度依赖这些模型。尽管它们提供了准确性和可扩展性,但也存在局限性。由于训练数据有限,它们可能会产生偏见或错误的响应,并且无法完全理解人类的语境和细微差别。

本文将探讨自托管 AI 模型的优势。自托管模型为企业提供了对 AI 基础设施的更大控制权,从而提高性能、适应性和数据隐私。通过在自己的服务器上托管模型,公司可以确保其专有数据保持在控制之下,并解决数据安全和隐私问题。

然而,自托管也存在挑战。它需要大量投资于硬件和专业知识来管理和维护基础设施。此外,将模型更新为包含新信息以及防范安全漏洞的责任完全落在公司身上。鉴于人工智能和网络安全领域的快速发展,这可能是一项艰巨的任务。

总而言之,大型语言模型代表了人工智能领域的一大进步,为企业提供了创新和提高效率的潜力。但其局限性以及微调和自托管的复杂性要求采取谨慎态度。公司需要权衡这些强大工具的优势与过度依赖、不准确性和伦理问题的风险。通过这样做,他们可以利用自托管 AI 模型的潜力,同时减轻与这些开创性技术相关的风险。

为什么不直接使用云端模型?

企业和个人选择自托管 AI 模型的原因有很多。主要原因之一是数据安全。当使用像 OpenAI 这样的提供商的模型时,输入数据可能被用作训练素材。通过自托管,公司可以确保其敏感数据保持在控制之下,并且不会被用于训练目的。

提示: 为了避免您的数据被美国 AI 提供商(例如 OpenAI)使用,请考虑运行“自托管” AI 模型。这需要一台配备 Nvidia GPU 且安装了相应“torch”的服务器。对于 DIY 用户,建议使用开源项目 Ollama (https://ollama.com )。或者,考虑使用德国的 KI 提供商,例如 document-chat.com (https://document-chat.com ) 或 DataFortress Cloud (https://datafortress.cloud )。document-chat.com 还提供基于项目的组织、有用的共享/团队功能等等!

另一个重要方面是成本节省。与使用第三方模型的高昂成本相比,自托管模型通常免费或仅需极少的许可费。这使得自托管模型成为所有规模的企业具有经济吸引力的选择。

隐私保护是另一个关键因素。通过自托管,公司保留其数据控制权,并确保数据不会与第三方共享。这在遵守严格数据隐私法规的行业中尤其重要。

总而言之,自托管 AI 模型具有提高数据安全、节省成本和保护隐私等优势。公司可以在充分控制其 AI 基础设施的同时,受益于这项强大技术的优势。

我需要什么来运营一个自托管 AI 模型?

运营自托管 AI 模型需要特定的资源。一个关键组件是 Nvidia GPU 服务器,因为 GPU 提供了强大的处理能力,用于训练和运行 AI 模型。但是,重要的是要注意,Nvidia GPU 服务器可能相当昂贵,代表着巨大的投资。

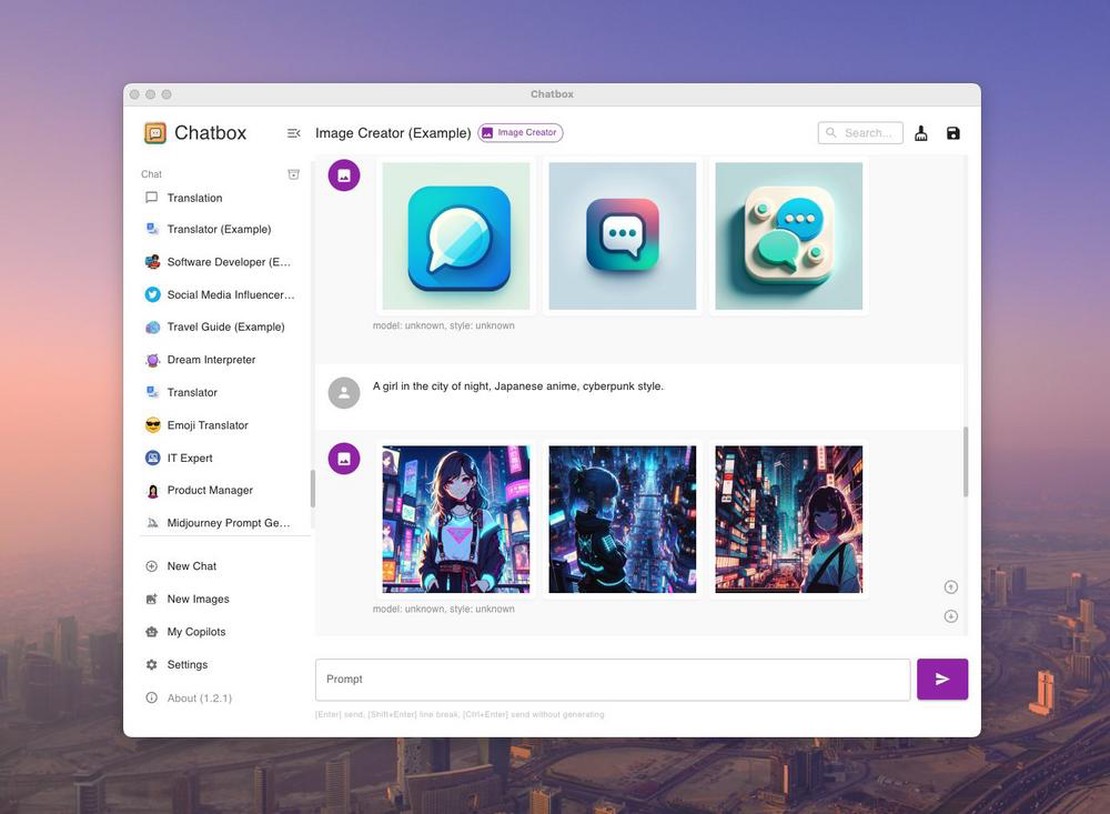

幸运的是,有一些开源项目,例如 Ollama (https://github.com/ollama/ollama ),可以简化模型托管。Ollama 提供了一种简单易用的方法来自托管模型。它提供了工具和资源来简化和自动化自托管流程。

使用 Ollama 和合适的 Nvidia GPU 服务器,您可以运行自己的 AI 模型,并且在无需承担专用服务器全部财务负担的情况下,就能受益于自托管的优势。

必须承认,运行自托管 AI 模型仍然需要专业技术知识。拥有机器学习和服务器管理的知识,或者咨询专家,有助于系统设置和维护。

凭借合适的资源和工具(例如 Ollama),您可以运行自己的 AI 模型,并利用自托管的优势来保持控制权、保护数据并节省成本。

我需要什么样的服务器来运行这些模型?

首先,评估您的需求。“代码助手”如 GitHub Copilot 需要的资源较少,可以使用具有约 8GB 显存的 GPU 运行。对于行为类似于 ChatGPT 的大型模型,至少需要 16GB 显存。如果您预见到与 GPT-4 相当的性能,则需要更强大的资源,理想情况下是一个至少具有 64GB 显存的 GPU 集群。

以下是模型及其内存需求的小型概述:

| 模型 | 参数 | 需要的显存 |

|---|