Introduction

Dans le monde de l’intelligence artificielle (IA), les grands modèles linguistiques tels que GPT (Generative Pre-trained Transformer) se sont imposés comme des outils puissants pour une multitude d’applications. Cependant, les entreprises doivent faire preuve de prudence en s’appuyant trop lourdement sur ces modèles. Bien qu’ils offrent précision et évolutivité, ils ont aussi leurs limites. Ils peuvent produire des réponses biaisées ou erronées en raison des limitations des données d’entraînement et ne sont pas capables de comprendre pleinement le contexte humain et les subtilités.

Dans ce billet de blog, nous examinerons les avantages des modèles IA hébergés en interne. Les modèles hébergés en interne offrent aux entreprises un plus grand contrôle sur leur infrastructure IA, ce qui peut conduire à de meilleures performances, une meilleure adaptation et une meilleure confidentialité. En hébergeant le modèle sur leurs propres serveurs, les entreprises peuvent s’assurer que leurs données propriétaires restent sous leur contrôle et s’attaquer aux préoccupations en matière de sécurité des données et de confidentialité.

Toutefois, l’hébergement interne présente également des défis. Il exige des investissements importants en matériel et en expertise pour gérer et entretenir l’infrastructure. De plus, l’entreprise est entièrement responsable de la mise à jour du modèle pour intégrer de nouvelles informations et de la protection contre les failles de sécurité. Face à la rapidité des progrès de l’IA et de la cybersécurité, cette tâche peut s’avérer complexe.

Dans l’ensemble, les grands modèles linguistiques représentent une avancée significative dans le domaine de l’IA et offrent aux entreprises un potentiel d’innovation et de gains d’efficacité. Cependant, leurs limites et la complexité de l’adaptation fine et de l’hébergement interne exigent une approche prudente. Les entreprises doivent évaluer les avantages de ces outils puissants contre les risques d’une dépendance excessive, d’inexactitudes et de préoccupations éthiques. En agissant ainsi, elles peuvent exploiter le potentiel des modèles IA hébergés en interne tout en minimisant les risques liés à ces technologies révolutionnaires.

Pourquoi ne pas simplement utiliser un modèle cloud ?

Plusieurs raisons poussent les entreprises et les particuliers à choisir l’hébergement interne des modèles IA. L’une des principales raisons est la sécurité des données. Lorsqu’on utilise des modèles de fournisseurs tels qu’OpenAI, il existe un risque que les données saisies soient utilisées comme données d’entraînement. En hébergeant en interne, les entreprises peuvent s’assurer que leurs données sensibles restent sous leur contrôle et ne sont pas utilisées à des fins d’entraînement.

Conseil : Pour éviter que vos données soient utilisées par les fournisseurs américains d’IA comme OpenAI, vous devriez opter pour un modèle IA “hébergé en interne”. Pour cela, vous avez besoin d’un serveur doté d’une carte graphique Nvidia et d’une configuration « torch » appropriée. Pour une solution DIY, le projet open source https://ollama.com est recommandé. Sinon, un fournisseur d’IA allemand est nécessaire, comme https://document-chat.com ou https://datafortress.cloud . Document-chat.com propose également la segmentation par projet, des fonctionnalités de partage/équipe utiles et bien plus encore !

Un autre point important est la réduction des coûts. Les modèles hébergés en interne sont généralement gratuits ou nécessitent peu de frais de licence par rapport aux coûts élevés associés à l’utilisation de modèles tiers. Cela fait des modèles hébergés en interne une option économiquement attrayante pour les entreprises de toutes tailles.

La protection de la vie privée est un autre facteur déterminant. En hébergeant en interne, les entreprises conservent le contrôle de leurs données et peuvent s’assurer qu’elles ne sont pas partagées avec des tiers. Ceci est particulièrement important dans les secteurs soumis à des réglementations strictes en matière de protection des données.

En résumé, l’hébergement interne des modèles IA offre des avantages tels que l’amélioration de la sécurité des données, des économies de coûts et le respect de la vie privée. Les entreprises peuvent conserver le plein contrôle de leur infrastructure IA tout en profitant des avantages de cette technologie puissante.

De quoi ai-je besoin pour exploiter un modèle IA hébergé en interne ?

Pour exploiter un modèle IA hébergé en interne, vous avez besoin de certaines ressources spécifiques. Un serveur doté d’une carte graphique Nvidia est essentiel, car les cartes graphiques offrent des performances de calcul élevées pour l’entraînement et l’exécution des modèles IA. Cependant, il est important de noter que les serveurs équipés de cartes graphiques Nvidia peuvent être assez coûteux et nécessiter un investissement important.

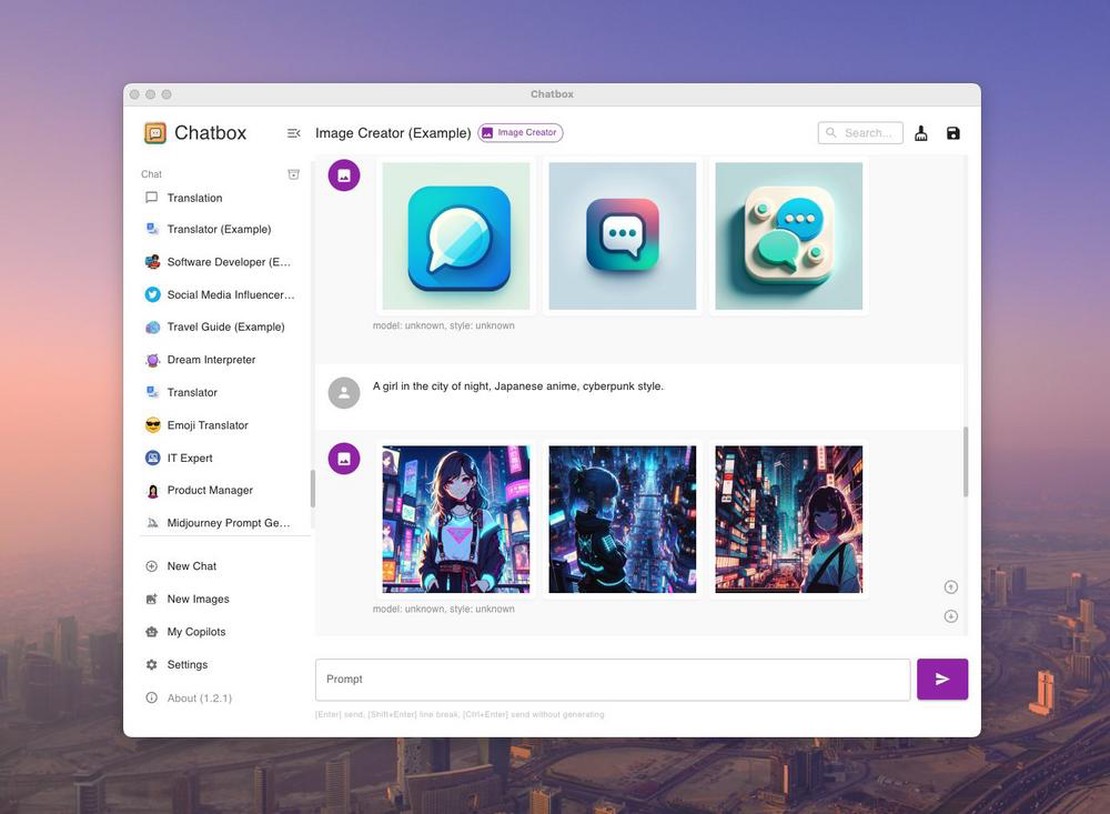

Heureusement, des projets open-source comme Ollama facilitent l’hébergement des modèles IA. Ollama est un projet sur GitHub (https://github.com/ollama/ollama ) qui offre un moyen simple et convivial d’héberger des modèles en interne. Il fournit des outils et des ressources pour simplifier et automatiser le processus d’hébergement interne.

Avec Ollama et un serveur doté d’une carte graphique Nvidia approprié, vous pouvez exploiter votre propre modèle IA et profiter des avantages de l’hébergement interne sans supporter la lourde charge financière d’un serveur dédié.

Il est important de noter que l’exploitation d’un modèle IA hébergé en interne reste exigeant en termes de connaissances techniques. Il peut être utile de posséder des compétences en apprentissage automatique et en administration de serveurs, ou de faire appel à des experts pour vous aider dans la configuration et la maintenance.

Avec les ressources et les outils appropriés, comme Ollama, vous pouvez exploiter votre propre modèle IA et profiter des avantages de l’hébergement interne pour garantir le contrôle, la sécurité des données et des économies de coûts.

Et quel serveur ai-je besoin pour les modèles ?

Tout d’abord, il faut évaluer les attentes vis-à-vis du modèle. Les “assistants de codage” du type Github Copilot nécessitent moins de ressources et peuvent fonctionner avec une carte graphique d’environ 8 Go de VRAM. Pour des modèles plus importants, similaires à ChatGPT, au moins 16 Go de VRAM sont nécessaires. Pour une performance équivalente à GPT-4, un cluster de cartes graphiques avec au moins 64 Go de VRAM est nécessaire.

Un petit aperçu des modèles et de la quantité de mémoire dont ils ont besoin se trouve ici :

| Modèle | Paramètres | VRAM requise |

|---|---|---|