DIY

Introducción

Los modelos lingüísticos grandes como GPT (Generative Pre-trained Transformer) se han convertido en herramientas poderosas para una amplia gama de aplicaciones en el mundo de la inteligencia artificial (IA). Sin embargo, las empresas deben ser cautelosas al confiar demasiado en estos modelos. Si bien ofrecen precisión y escalabilidad, también tienen limitaciones. Pueden producir respuestas sesgadas o incorrectas debido a las limitaciones en sus datos de entrenamiento, y no son capaces de comprender completamente el contexto y las sutilezas humanas.

Introducción

En el mundo de la inteligencia artificial (IA), los grandes modelos lingüísticos como GPT (Generative Pre-trained Transformer) se han consolidado como herramientas potentes para diversas aplicaciones. Sin embargo, las empresas deben ser cautelosas al depender demasiado de estos modelos. Si bien ofrecen precisión y escalabilidad, también tienen sus limitaciones. Pueden proporcionar respuestas sesgadas o incorrectas debido a las limitaciones de los datos de entrenamiento y no son capaces de comprender completamente el contexto y los matices humanos.

El problema: El 75% de las empresas prohíbe el uso de ChatGPT

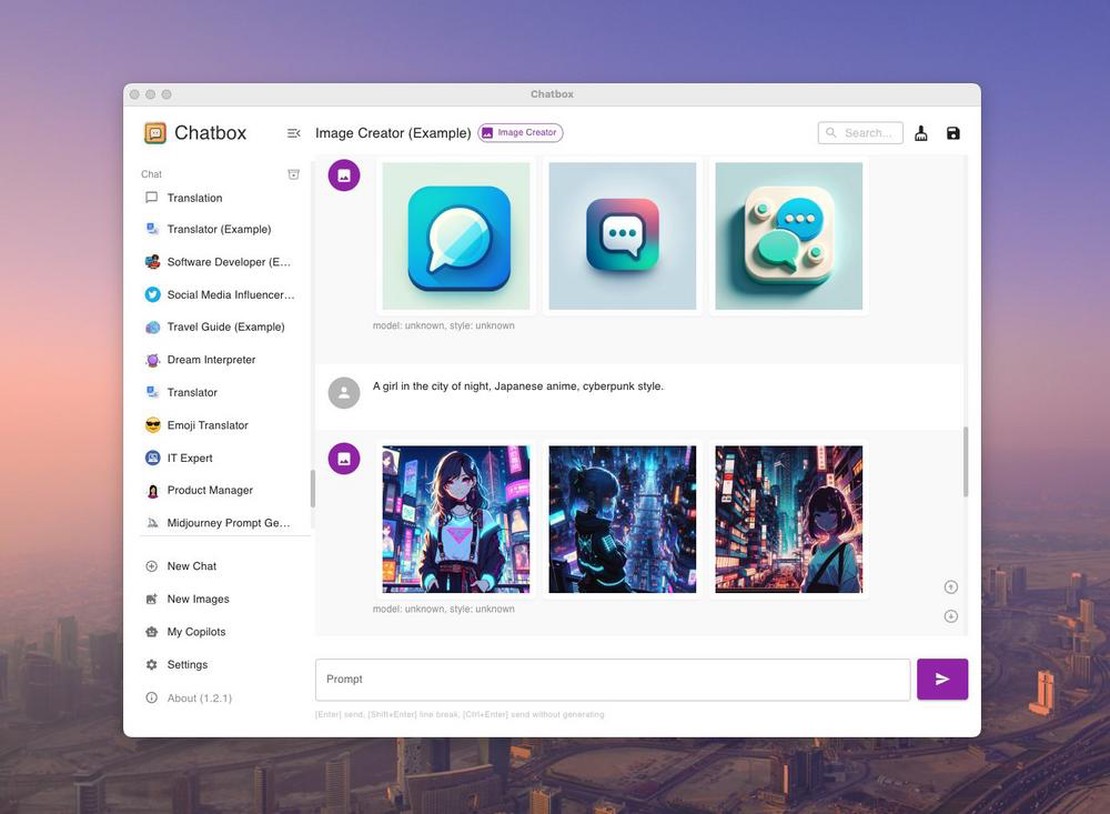

A pesar de la entusiasta acogida inicial a las herramientas de IA generativas como ChatGPT, las empresas están reconsiderando su uso debido a crecientes preocupaciones sobre la privacidad de datos y la ciberseguridad. La principal preocupación es que estas herramientas de IA almacenen y aprendan de los datos de los usuarios, lo que podría provocar filtraciones de datos no deseadas. Aunque OpenAI, el desarrollador de ChatGPT, ofrece una opción para “optar por no participar” en el entrenamiento con datos de usuarios, la forma en que se manejan los datos dentro del sistema sigue sin estar clara. Además, faltan normativas claras sobre la responsabilidad ante las violaciones de datos causadas por la IA. Por consiguiente, las empresas son cada vez más cautelosas y esperan a ver cómo evoluciona la tecnología y su regulación.

El Problema: El 75% de las Empresas Prohíbe ChatGPT

A pesar del entusiasmo inicial por las herramientas de IA generativa como ChatGPT, las empresas están restringiendo su uso debido a las crecientes preocupaciones sobre la privacidad de los datos y la ciberseguridad. La principal preocupación es que estas herramientas de IA almacenan y aprenden de los datos del usuario, lo que potencialmente puede dar lugar a violaciones de datos no deseadas. Aunque OpenAI, el desarrollador de ChatGPT, ofrece una opción para optar por no participar en el entrenamiento con datos de usuario, la gestión de los datos dentro del sistema sigue sin estar clara. Además, faltan regulaciones legales claras sobre la responsabilidad de las violaciones de datos causadas por la IA. En consecuencia, las empresas se muestran reticentes y esperan que la tecnología y su regulación evolucionen.