Introducción

En el mundo de la inteligencia artificial (IA), los grandes modelos lingüísticos como GPT (Generative Pre-trained Transformer) se han consolidado como herramientas potentes para diversas aplicaciones. Sin embargo, las empresas deben ser cautelosas al depender demasiado de estos modelos. Si bien ofrecen precisión y escalabilidad, también tienen sus limitaciones. Pueden proporcionar respuestas sesgadas o incorrectas debido a las limitaciones de los datos de entrenamiento y no son capaces de comprender completamente el contexto y los matices humanos.

En este artículo de blog, exploraremos los beneficios de los modelos de IA autohospedados. Los modelos autohospedados ofrecen a las empresas un mayor control sobre su infraestructura de IA, lo que puede conducir a un mejor rendimiento, adaptabilidad y privacidad. Al hospedar el modelo en sus propios servidores, las empresas pueden garantizar que sus datos propietarios permanezcan bajo su control y abordar las preocupaciones sobre la seguridad y la privacidad de los datos.

Sin embargo, el autohospedaje también presenta desafíos. Requiere una importante inversión en hardware y conocimientos técnicos para administrar y mantener la infraestructura. Además, la responsabilidad de actualizar el modelo para incorporar nueva información y proteger contra vulnerabilidades de seguridad recae completamente en la empresa. Dado el rápido avance de la IA y la ciberseguridad, esta puede ser una tarea compleja.

En general, los grandes modelos lingüísticos representan un avance significativo en la IA y ofrecen a las empresas el potencial de innovación y aumento de eficiencia. Sin embargo, sus limitaciones y la complejidad de la afinación y el autohospedaje requieren un enfoque cauteloso. Las empresas deben sopesar las ventajas de estas potentes herramientas frente a los riesgos de una dependencia excesiva, las imprecisiones y las preocupaciones éticas. Al hacerlo, pueden aprovechar el potencial de los modelos de IA autohospedados al tiempo que minimizan los riesgos asociados a estas tecnologías innovadoras.

¿Por qué no usar simplemente un modelo en la nube?

Hay varias razones por las que las empresas y las personas optan por autohospedar modelos de IA. Una de las principales es la seguridad de los datos. Al utilizar modelos de proveedores como OpenAI, existe la posibilidad de que los datos ingresados se utilicen como material de entrenamiento. Autohospedando, las empresas pueden garantizar que sus datos confidenciales permanezcan bajo su control y no se utilicen con fines de entrenamiento.

Sugerencia: Para evitar que los proveedores de IA estadounidenses como OpenAI usen sus datos, debe ejecutar un modelo de IA “autohospedado”. Para esto, necesita un servidor con una GPU Nvidia y una configuración “torch” adecuada. Para soluciones de bricolaje, se recomienda el proyecto de código abierto https://ollama.com . Como alternativa, se necesita un proveedor de IA alemán, como https://document-chat.com o https://datafortress.cloud . document-chat.com también ofrece la división por proyectos, funciones útiles de intercambio y colaboración y mucho más.

Otro aspecto importante es el ahorro de costes. Los modelos autohospedados suelen ser gratuitos o implican pequeñas tarifas de licencia en comparación con los altos costos asociados con el uso de modelos de terceros. Esto convierte a los modelos autohospedados en una opción económica atractiva para empresas de cualquier tamaño.

La protección de la privacidad es otro factor crucial. Al autohospedar, las empresas mantienen el control de sus datos y pueden asegurar que no se compartan con terceros. Esto es especialmente importante en industrias con estrictas regulaciones de privacidad de datos.

En resumen, autohospedar modelos de IA ofrece ventajas como una mejor seguridad de los datos, ahorro de costes y protección de la privacidad. Las empresas pueden mantener el control total de su infraestructura de IA y, al mismo tiempo, beneficiarse de las ventajas de esta potente tecnología.

¿Qué necesito para ejecutar un modelo de IA autohospedado?

Para ejecutar un modelo de IA autohospedado, necesita algunos recursos específicos. Un componente importante es un servidor con GPU Nvidia, ya que las GPU proporcionan un alto rendimiento de cálculo para el entrenamiento y la ejecución de modelos de IA. Sin embargo, es importante tener en cuenta que los servidores con GPU Nvidia pueden ser bastante costosos y requerir una inversión considerable.

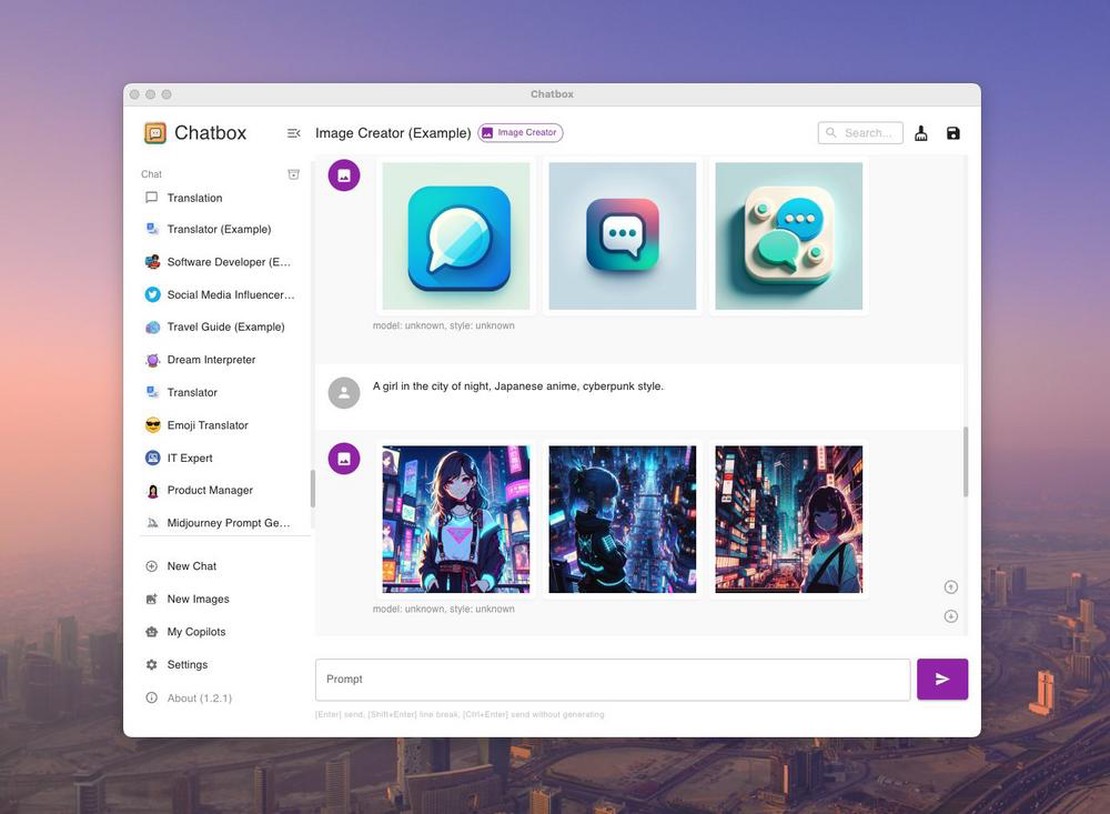

Afortunadamente, existen proyectos de código abierto como Ollama que facilitan el hospedaje de modelos de IA. Ollama es un proyecto en GitHub (https://github.com/ollama/ollama ) que ofrece una forma sencilla y fácil de usar de autohospedar modelos. Ofrece herramientas y recursos para simplificar y automatizar el proceso de autohospedaje.

Con Ollama y un servidor con GPU Nvidia adecuado, puede ejecutar su propio modelo de IA y beneficiarse de las ventajas del autohospedaje sin asumir la carga financiera completa de un servidor dedicado.

Es importante tener en cuenta que la ejecución de un modelo de IA autohospedado sigue requiriendo conocimientos técnicos. Puede ser útil contar con conocimientos en aprendizaje automático y administración de servidores o recurrir a expertos para que le ayuden con la configuración y el mantenimiento.

Con los recursos y herramientas adecuados, como Ollama, puede ejecutar su propio modelo de IA y aprovechar las ventajas del autohospedaje para obtener control, seguridad de los datos y ahorro de costes.

¿Y qué tipo de servidor necesito para los modelos?

En primer lugar, debe sopesar lo que espera del modelo. Los “asistentes de codificación” como Github Copilot requieren menos recursos y pueden funcionar con una GPU con ~8 GB de VRAM. Para modelos más grandes que se comportan de forma similar a ChatGPT, se necesitan al menos 16 GB de VRAM. Si se espera un rendimiento similar al de GPT-4, la situación requiere mayor presupuesto, y debe considerar un clúster de GPU con al menos 64 GB de VRAM.

Aquí hay una pequeña descripción general de los modelos y la cantidad de memoria que necesitan:

| Modelo | Parámetros | VRAM necesaria |

|---|---|---|